Diagnosis

In some tests, in-depth training already works better than expert people

One evening last November 54 Year-old woman from the Bronx arrived at the emergency room of the Columbia University Medical Center with a complaint of severe headache. Everything was blurred before her eyes, and her left hand was numb and weakened. The doctors examined her and recommended computer tomography of the head.

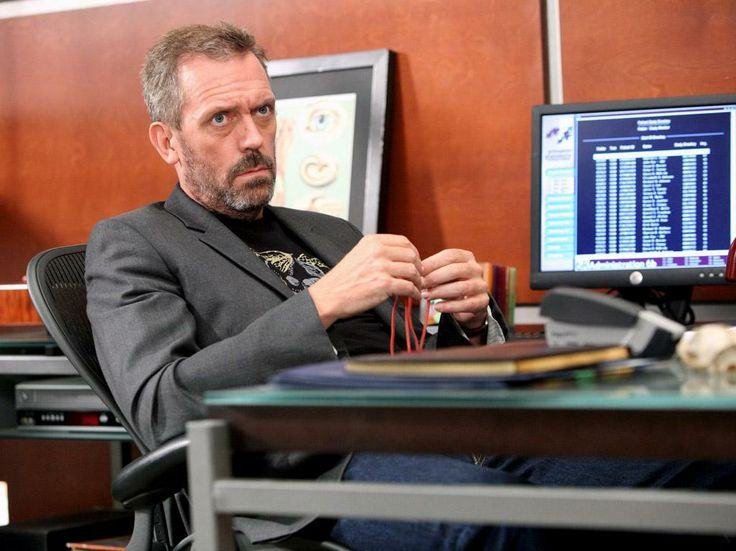

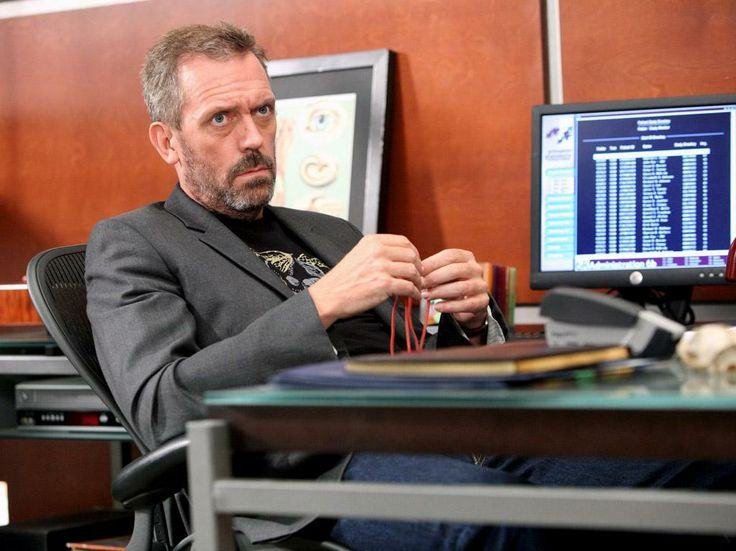

A few months later, in the morning of one of the January days, four future radiologists gathered in front of the computer screen on the third floor of the hospital. The room had no windows, and only the screen turned on. Angela Lineley-Dipll [Angela Lignelli-Dipple]head of the department of neuroendology of the university, stood behind the interns with a pencil and a tablet. She taught them to understand CT images.

“When the brain is dead, it’s easy to diagnose a stroke,” she says. “The trick is to diagnose a stroke before too many nerve cells die.” Strokes usually occur because of blockage of blood flow or bleeding, and the neuroscientist has only 45 minutes to make a diagnosis so that the doctors can intervene in the process – for example, to eliminate the emerging clot. “Imagine that you are in the emergency room,” the Lineel-Dipl.-continued, increasing the intensity of the imaginary situation. – Every minute another section of the brain dies. Lost time is a lost brain. ”

She glanced at the clock on the wall, on the dial of which ran a second hand. “Well, what’s the problem?” She asked.

Usually strokes are asymmetric. The supply of the brain with blood splits left and right, and then divides into streamlets and tributaries from each side. A blood clot or bleeding usually affects one of the branches, which leads to a deficit on one side of the brain. When the nerve cells are cut off from the influx of blood and begin to die, they swell a little. In the picture, clear boundaries between the anatomical structures may be blurred. Eventually, the fabric contracts, leaving a dried shadow on the image. But this shadow is still visible in the pictures in a few hours or even days after the stroke, when the possibility of intervention has already been missed. “Until now,” Linelie-Diplle told me, “there is a hint in the picture,” a warning of an impending stroke.

A woman’s brain shot from the Bronx slits the skull from the base to the top, like a slice of watermelon cut from the top down. Internals quickly scanned the layers of images, as if leafing through the pages of the notebook, calling the anatomical structures: the cerebellum, the hippocampus, the central part, the striatum, the corpus callosum, the ventricles. Then one of the students, whose age was approaching 30 years, stopped on one of the pictures and pointed with a pencil on the area from the right side of the brain. “There is something patchy here,” he said. “The borders look blurry.” From my point of view, the whole image looked blotchy and blurry – like a porridge of pixels – but he clearly saw something unusual.

“Blurry?”, – supported its Liney-Dipl. “Please describe in more detail.”

Intern began to mumble something. He stopped, as if he were touching the anatomical structures in his head, weighing the possibilities. “She’s just not uniform,” he shrugged. – I dont know. It looks strange. ”

Lyneli-Dipll opened the next set of CT images taken in 24 hours. The area, the size of the grape, to which the resident indicated, was dull and bloated. A few subsequent shots taken a few days apart told the rest of the story. A gray wedge-shaped region appeared. Shortly after entering the emergency room, the neurologist tried to clear the clogged artery with a drug that dissolves the clots, but he arrived too late. A few hours after the initial shot, she lost consciousness, and she was transferred to the intensive care unit. Two months later she was still in the ward. The left side of her body, including her arm and leg, was paralyzed.

Linelie-Dipll and I went to her office. I had to study the process of training in the hospital: how do doctors learn to make diagnoses? Can this be learned by machines?

My initiation into diagnostics began in autumn 1997 in Boston, when I went to practice after the medical institute. For preparation, I read a classic medical textbook that divided the process of making a diagnosis into four distinct phases. First, the doctor uses the patient’s medical history and physical examination to gather facts about her complaints or condition. Then the information is critically examined in order to create an exhaustive list of potential causes of the problems. After that questions and preliminary checks help to exclude some hypotheses and strengthen others – this is the so-called. “Differential diagnosis”. Such parameters as the prevalence of the disease, the history of the disease, risks, possible effects on a person are taken into account (as the well-known medical aphorism says [американский]”trampling of horses’ hoofs rather than zebras” [“зебра” в медицине США – сленговое название постановки экзотического диагноза в случае, когда наиболее вероятен более простой диагноз]). The list narrows: the doctor clarifies his assumptions. In the final phase, laboratory tests, X-rays or CT confirm the hypothesis and diagnosis. The variants of this step-by-step process were reproduced in medical textbooks for decades, and the idea of diagnostics, methodically and boringly moving from symptoms to cause, was inspired by generations of medical students.

But the real art of diagnosis, as I learned later, is not so straightforward. My mentor at the medical school was an elegant New Englander in polished moccasins and with a stiff accent. He considered himself an expert diagnostician. He asked the patient to demonstrate a symptom – for example, a cough – and then leaned back in his chair and rolled over his adjectives. “Rattling and metallic,” he could say, or, “low, with strumming,” as if describing a vintage bottle of Bordeaux. All the cadets seemed alike to me, but I played along with it: “Rattling, yeah,” feeling like an impostor at a wine tasting.

A cough specialist could immediately narrow the possibilities of diagnosis. “It sounds like pneumonia,” he could say. Or: “a wet wheeze with congestive heart failure.” Then he gave out a stream of questions. Did the patient gain weight recently? Did he have contact with asbestos? He asked the patient to cough again and leaned over, listening with a stethoscope. Depending on the answers, he could issue a new series of possibilities, as if amplifying and weakening synapses. Then, with the pomp of the wandering magician, he proclaimed the diagnosis: “heart failure!” – and wrote out tests to prove his case. He was usually right.

A few years ago, Brazilian researchers studied the brains of expert radiologists to understand how they give out their diagnoses. Did these experienced diagnosticians refer to a mental “rulebook” or did they use “pattern recognition and non-analytic reasoning”?

Twenty-five radiologists were asked to evaluate lung X-rays, and at that time, the activity of their brain was monitored by MRI . (There are many wonderful recursions: to diagnose the diagnosis process, you need to make a photo of people studying the photo). X-rays were flashed before the eyes of the subjects. Some have depicted common pathological lesions – for example, a shadow of pneumonia in the form of a brush, or a gray opaque wall of fluid that accumulates behind the shell. The second group of pictures included contour drawings of animals. In the third there were contours of the letters of the alphabet. Radiologists were shown these pictures randomly, asked them to pronounce aloud the name of the damage, animal or letter as quickly as possible, and at that time the MRI device monitored the activity of their brain. On average, a diagnosis of x-rays required 1.33 seconds. In all three cases, the same part of the brain “lit up” the same part of the brain: a wide delta of neurons near the left ear and a strip in the form of a moth at the posterior base of the skull.

“Our results support the hypothesis that when a physician recognizes a known The damage works the same process that is associated with the naming of objects, “- concluded the researchers. The definition of damage is very similar to the definition of an animal. When you recognize a rhino, you do not consider alternative candidates to drop the wrong choices. You do not combine mentally a unicorn, a battleship and a small elephant. You recognize the rhino as a whole – as an image. The same thing happens with radiologists. They did not weigh, remember, or differentiate. They just saw a famous object. For my mentor, wet rales were as familiar as the famous melody.

In 1945, the British philosopher Gilbert Ryle gave a fateful lecture on two types of knowledge. The child knows that the bicycle has two wheels, the tires are filled with air, and you need to drive it by rotating the pedal around it. Ryle called this knowledge – the actual, the propositional – “knowing what.” But to learn how to ride a bicycle, you need to turn to another area of training. The child learns to ride a bicycle, falling from it, balancing on two wheels, overcoming the pits. Ryle called this knowledge – hidden, experimental, based on skills – “knowledge of how.”

It would seem that these two types of knowledge are interdependent: one can use knowledge of facts to deepen experimental knowledge, and vice versa. But Rile warned against the temptation to think that “knowledge as” can be reduced to “knowing what” – you can not learn to ride a bicycle in the book of rules. Our rules, he argued, make sense only because we know how to use them: “Rules, like birds, must be alive before they can be made stuffed.” One day I watched as my seven-year-old daughter crossed a hill on a bicycle. For the first time, it got stuck on its steepest part and fell. The second time she bent forward, at first almost imperceptibly, and then more and more, and carried the weight back, when the curvature of the hill began to decrease. But I did not teach her the rules by which you need to climb this hill by bike. I think that when her daughter crosses the same hill, she will not teach her either. We meet a few rules on which the universe works, but we let the brain learn all the others.

Some time after meeting with interns-radiologists, I spoke with Stephen Haider, a young man who noticed signs of a stroke on a CT scan. How did he discover this damage? Was it “knowledge of what” or “knowledge of how”? He began to talk about learned rules. He knew that strokes are usually one-sided, that they lead to “worn out” tissue, that the fabric sometimes swells a little, because of what the anatomical boundaries disappear. “There are places in the brain where the blood flow is particularly wounded,” he said. To determine the damage, you need to look for its signs on one side, and look to see that they are not on the other.

I reminded him that the photograph had many asymmetrical details ignored by him. This image to the left had a lot of gray scribbles – possibly artifacts associated with movement, or accidental, or brain changes that preceded the stroke. How did he concentrate only on this area? He paused for a moment to gather his thoughts. “I do not know – in part it was subconscious,” he said at last.

“That’s what happens – everything falls into place – when you grow and learn as a radiologist,” says Lyneli-Dipl. The question is whether the machine can “grow and learn” in the same way.

In January 2015, computer scientist Sebastian Troon [Sebastian Thrun] was carried away by the mystery of medical diagnostics. Troon, who grew up in Germany, is thin, with a shaved head and a sense of comic; He looks like a strange hybrid of Michel Foucault and Mr. Bean. The former Stanford professor, who ran the AI laboratory there, Trun left to lead Google X, lead the creation of self-learning robots and robots. But he discovered a predilection for trained medical devices. His mother died of breast cancer when she was 49 – as many as now to Trun. “Most patients with cancer have no symptoms at first,” Troon told me. “My mother did not have them.” When she went to the doctor, her cancer already metastasized. I became obsessed with the idea of detecting cancer at an early stage – when it can still be cut with a knife. And I was thinking, can the machine learning algorithm help in this? »

What is stronger, body or mind?

– Get up.

– No.

Early attempts to establish automatic diagnoses tried to work on a textbook and with exact knowledge. Take an electrocardiogram showing the electric activity of the heart in the form of lines on a page or screen. For the past 20 years, such systems have often used computer interpretations. The program working with the data is fairly straightforward. Characteristic forms of waves are associated with various problems – atrial fibrillation or blockage of the vessel – and the device incorporates rules for recognizing these waveforms. When the machine recognizes the waveform, it marks the heartbeat as “atrial fibrillation.”

In mammography, “computer-assisted detection” also becomes common. The software recognizes suspicious areas in an image, and the radiologist examines the results. But usually this software uses a system based on rules, and determines for them a suspicious damage. These programs do not have a learning mechanism: a machine that has seen three hundred x-ray images is no better than the one that saw four. These limitations became clearly visible after the 2007 study, comparing the accuracy of mammography before and after the introduction of devices with computer diagnostics. One would expect a sharp increase in accuracy – but it turns out that the effect was more complicated. The number of biopsies has increased manyfold. And the detection of small invasive tumors – just those that seek to identify oncologists – decreased. More recent studies have shown an increase in problems with false detection of tumors.

Troon was convinced that he could surpass precisely the first-generation devices by moving from algorithms based on rules to learners-that is, from diagnosing based on “knowledge” That “to the formulation with the help of” knowledge as “. Increasingly, such learning algorithms, with which Troon works, use a computer strategy called “neural network”, inspired by the work of the brain itself. In the brain, the nerve synapses are amplified or weakened through periodic activation; Digital systems try to achieve this result through mathematics, adjusting the “weights” of the links to obtain the desired output data. The most powerful of the networks resemble the layers of neurons, each of which processes the input data and sends the results to the next layer – hence the name “deep training.”

Trun began with skin cancer; Specifically – keratinocytic carcinoma (the most common cancer in the US) and melanoma (the most dangerous type of skin cancer). Is it possible to teach a machine to distinguish between skin cancer and its more favorable condition – acne, rash, birthmark – by photo scan? “If dermatologists are capable of this, then the machine must cope,” Trun argued. “Perhaps the machine will do even better.”

Usually, dermatologists are taught to recognize melanoma on the basis of a set of rules denoted by the mnemonic abbreviation ABCD. Melanomas are often asymmetric (A), their borders (border, B) are uneven, their color (color, C) is uneven and variegated, and diameter (D) is usually greater than 6 mm. But when Trun looked through the examples with melanomas in medical textbooks and on the net, he discovered instances to which none of these rules were applicable.

Trun, who worked as an associate professor at Stanford, created the team along with two of his students for Named after Andre Estev and Bret Kuprel. Their first task was to create a training set: an extensive collection of images used to teach machine recognition of malicious education. On the Internet, Esteva and Kuprel found 18 images storages with skin lesions classified by dermatologists by type. These galleries contained almost 130,000 images – acne, rash, insect bites, allergic reactions and cancers – which dermatologists divided into almost two thousand diseases. There was also a set of two thousand skin formations, according to which pathologists were biopsy, and therefore they were diagnosed with high accuracy.

Esteva and Kuprel began to train the system. They did not program the rules into it, they did not teach it to the ABCD system. They fed neural networks images and their diagnoses. Я попросил Труна описать, что делала эта сеть.

«Представьте классическую программу, пытающуюся определить собаку, – говорит он. – Программисту пришлось бы вписать в неё тысячу условий „если/то“: если у неё есть уши, морда, волосы, и если это не крыса, и т.п. – до бесконечности. Но ребёнок учится распознавать собак по-другому. Сначала он видит собак, и ему говорят, что это собаки. Он ошибается и поправляется. Он думает, что волк – это собака, но ему говорят, что это не так. Он постепенно меняет своё понимание – это собака, а то – волк. Алгоритм машинного обучения, как ребёнок, берёт информацию из предварительно классифицированного тренировочного набора. Вот собака, вот не собака. Затем он извлекает особенности, отличающие один набор от другого. Проверяя себя на тысячах классифицированных изображений, он начинает самостоятельно создавать свой способ распознавания собаки – так же, как ребёнок». Она просто знает, как это делать.

В июне 2015 команда Труна начала проверять, чему машина научилась на основе стартового набора, представив ей проверочный набор: 14000 изображений, с диагнозами, проставленными дерматологами (не обязательно на основе биопсии). Могла ли система классифицировать изображения по трём диагностическим категориям: неопасные образования, злокачественные образования и нераковые опухоли? Система дала правильный ответ в 72% случаев (реальный выход алгоритма – не «да/нет», а вероятность принадлежности рассматриваемого образования к данной категории). Два сертифицированных дерматолога, рассматривавшие те же изображения, справились зуже: они дали правильный ответ в 66% случаев.

Трун, Эстева и Курпель расширили исследование, пригласив двадцать пять дерматологов, и на этот раз использовали тестовый набор из двух тысяч изображений, диагноз которых был подтверждён биопсией. Почти в каждом тесте машина оказалась более чувствительной, чем врачи: вероятность пропустить меланому оказалась ниже. «В любом тесте сеть победила экспертов-дерматологов», – заключила команда в отчёте, опубликованном в Nature.

«Одна удивительная деталь, связанная с сетью, не была должным образом освещена в работе», – рассказал мне Трун. На первой фазе исследования он с командой начал работу с «чистой» сетью. Но они обнаружили, что если начинать работу с сетью, предварительно натренированной на распознавание каких-нибудь не связанных с темой вещей (к примеру, отличать кошек от собак), она обучалась лучше и быстрее. Возможно, и наш мозг работает так же. Изматывающие и отупляющие сознание уроки в старших классах школы – перемножение многочленов, поиск корней глаголов, запоминание периодической таблицы – возможно, как раз наоборот, повышали чувствительность разума.

Обучая машину, команде пришлось обрабатывать картинки. Трун надеется, что когда-нибудь люди смогут отправлять фотографии беспокоящих их образований, сделанные при помощи смартфона. А это значит, система не должна бояться широкого спектра углов и условий освещения. Но, он вспоминает, что: «на некоторых изображениях меланомы были помечены жёлтыми дисками. Приходилось их вырезать, иначе компьютер просто научился бы распознавать жёлтый диск как рак».

Была такая старая загадка: сто лет назад немецкая публика была поражена шоу «Умного Ганса», с участием лошади, якобы умевшей складывать и вычитать, и передававшей свои ответы при помощи боя копытом. Оказалось, что «Умный Ганс» на самом деле распознавал поведение своего хозяина. Когда количество ударов копыта приближалось к правильному ответу, наездник расслаблялся. Нейросеть животного не обучилась арифметике, она научилась отслеживать изменения в языке тела человека. «Такая вот странная особенность нейросетей, – говорит Трун. – Вы не знаете, чему конкретно они обучаются. Это как чёрный ящик, принцип работы которого неизвестен».

Проблема «чёрного ящика» свойственна глубинному обучению. Система работает не по набору медицинских знаний и правил диагностики. Она сама научила отличать родинки от меланом путём множества подстроек внутренних параметров – похожим образом усиливаются и ослабляются нейронные связи мозга. Каким образом она определила, что это образование – меланома? Мы этого не узнаем, и она нам не расскажет. Все внутренние подстройки и обработка данных ускользают от нашего надзора. Как и в случае с нашим мозгом. При медленном развороте на велосипеде вы отклоняетесь в обратную сторону. Моя дочь знает, как это делать, но она не знает, что она это делает. Машина по поиску меланом, наверное, извлекает определённые свойства изображений. Так ли важно, что она не может сказать, какие именно это свойства? Она похожа на улыбающегося бога знаний. Познакомившись с её работой, можно представить, как животные воспринимают разум человека: всезнающий, но непознаваемый.

Трун оптимистично глядит в будущее, в котором мы находимся под постоянным диагностическим контролем. Наши телефоны будут отслеживать изменения в речи, чтобы диагностировать приближающуюся болезнь Альцгеймера. Руль определит начинающуюся болезнь Паркинсона по небольшой дрожи. Ванная, пока вы моетесь, будет делать вам УЗИ или МРТ, чтобы определить, не появилось ли внутри вас новое подозрительное образование. Большие данные будут следить, записывать и оценивать: мы будем переходить от одного алгоритма к другому. Войти в труновский мир умных ванных комнат и рулей – это войти в комнату с диагностическими зеркалами, каждое из которых требует новых тестов.

Тяжело не поддаться очарованию такого видения. Позволит ли медицинский паноптикум, постоянно сканирующий нас на клеточном уровне, ежедневно сравнивающий изображения, помочь нам отловить рак на ранних стадиях? Обеспечит ли он нам прорыв в обнаружении рака? Звучит впечатляюще, но есть и подвох: многие виды рака не распространяются по организму. Мы умираем вместе с ними, а не из-за них. Что, если такая огромная машина диагностики приведёт к проведению миллионов ненужных биопсий? В медицине бывают случаи, когда ранний диагноз может сохранить или продлить жизнь. А бывают случаи, когда вы дольше будете волноваться, но жить дольше не будете. Сложно сказать, как много вам нужно знать.

«Мне хочется увеличить возможности людей, – говорит Трун, когда я спрашиваю его по поводу последствий, которые такие системы несут для людей, работающих диагностами. – Устранило ли современное сельское хозяйство некоторые виды возделывания земли? Конечно, но оно и увеличило наши возможности производства сельскохозяйственных товаров. Не всех всё устроило, но мы теперь можем кормить больше людей. Индустриальная революция увеличила силу мускулов человека. Используя телефон, вы усиливаете человеческую речь. Вы не сможете докричаться до Калифорнии из Нью-Йорка, – а мы с Труном при этом разговоре как раз находились на таком расстоянии, – но это прямоугольное устройство у вас в руке позволяет передавать голос на расстояние в три тысячи миль. Заменил ли телефон голос? Нет, телефон – это дополняющее устройство. Революция в когнитивистике позволит компьютерам усиливать возможности человеческого разума тем же образом. Так же, как машины в тысячу раз увеличили силу мускулов, машины сделают человеческий мозг в тысячу раз сильнее». Трун настаивает, что эти устройства глубинного обучения не заменят дерматологов и рентгенологов. Они дополнят профессионалов, предложив им экспертное мнение и помощь.

Джеффри Хинтон, специалист по информатике из Торонтского университета, не так мягко рассказывает о роли обучающихся машин в клинической медицине. Хинтон – прапраправнук Джорджа Буля, чья Булева алгебра служит краеугольным камнем в цифровых вычислениях. Хинтона иногда называют отцом глубинного обучения; над этой темой он работал с середины 70-х, и многие его студенты стали главными архитекторами сегодняшних обучающихся систем.

«Думаю, что если вы работаете рентгенологом, то ваша работа похожа на действия койота из мультика, Wile E. Coyote. Вы уже зашли за край обрыва, но ещё не посмотрели вниз. А под вами уже нет опоры».

Коммерческие системы глубинного обучения для обработки снимков груди и сердца уже разрабатываются. «Просто уже совершенно очевидно, что за пять лет глубокое обучение будет работать лучше рентгенологов, – продолжает он. – Может, через десять лет. Я как-то сообщил об этом в госпитале, и восприняли это не очень благосклонно».

Речь Хинтона в том госпитале на самом деле была довольно прямолинейной: «Пора уже заканчивать обучать на рентгенологов». Когда я обсудил этот вопрос с Анджелой Линели-Дипл, она указала, что диагностика рентгена не ограничивается ответами «да/нет». Рентгенологи не просто определяют эмболию, приведшую к инсульту. Они замечают кровотечение где-то ещё, предотвращая опасное в таких случаях использование лекарств, растворяющих сгустки. Они замечают неожиданную, не такую симптоматичную опухоль.

Хинтон оценивает провокацию. «Роль рентгенологов будет развиваться от распознавательной работы, которую, вероятно, может выполнять дрессированный голубь, к выполнению более когнитивных вещей», – говорит он. Его прогноз будущего автоматической медицины основан на простом принципе: «Возьмите любую задачу классификации, по которой у вас есть много данных, и глубинное обучение сможет её решить. Для ГО будут тысячи применений». Он хочет использовать обучающиеся алгоритмы для чтения снимков от рентгеновских аппаратов, КТ и МРТ, снимков любого типа – и это только среднесрочный прогноз. Он утверждает, что в будущем «обучающиеся алгоритмы будут выдавать и диагнозы патологий». Они смогут делать заключение по поводу мазка Папаниколау, слушать работу сердца или предсказывать рецидивы у пациентов психиатрических клиник.

Мы обсудили проблему чёрного ящика. Хотя программисты и работают над этим, Хинтон признал, что задача вскрытия чёрного ящика, с тем, чтобы разобраться, что именно известно системе и откуда, «далека от тривиальной – не верьте тем, кто утверждает обратное». Но он считает, что с этой проблемой можно смириться. «Представьте, что игрок в бейсбол и физик соревнуются в вычислении места приземления мяча, – говорит он. – Игрок, миллион раз бросавший мяч, может не знать всех этих уравнений, но он точно знает, как высоко пойдёт мяч, какую он наберёт скорость и где он упадёт. Физик может написать уравнения, чтобы узнать то же самое. Но они оба придут к одному результату».

Я вспомнил разочаровывающие результаты компьютерных диагностических систем для маммографии прошлого поколения. Хинтон признал, что любую новую систему придётся проводить через тщательные клинические испытания. Но он настаивает на том, что новые системы учатся на своих ошибках и со временем исправляются. «Можно сделать систему, при которой каждый упущенный диагноз – человек, у которого всё-таки возникла опухоль – скармливался в машину. Мы можем спросить, что тут упущено? Можно ли улучшить диагноз? Такой системы для рентгенологов нет. Если вы что-то пропустите, а через пять лет у человека появится опухоль, то нет рутинной процедуры, которая бы помогла вам исправиться. Но можно сделать систему, в которой компьютер будет делать именно это».

Некоторые из наиболее амбициозных проектов по созданию диагностических машин пытаются интегрировать обработку естественного языка (чтобы машина могла прочесть историю болезни) и энциклопедические знания по медицине из учебников, журналов и медицинских баз данных. Проекты IBM Watson Health в Кембридже, Массачусетс, и DeepMind в Лондоне надеются создать именно такие сложные системы. Я смотрел демонстрации их работы, но многие из заявленных возможностей пока ещё находятся на стадии разработки.

Хинтон со страстью относится к будущему диагнозов на основе глубинного обучения, не в последнюю очередь благодаря и своему опыту. Когда он разрабатывал подобные алгоритмы, у его жены нашли рак поджелудочной. У сына обнаружили злокачественную меланому, но биопсия показала, что это образование — базалиома, рак не такого страшного типа. «Нам ещё многому нужно учиться, – сказал Хинтон, с тихим вздохом. – Ранняя и точная диагностика – нетривиальная задача. Мы можем улучшить наши показатели. Почему бы не дать машинам помочь нам?»

Холодным мартовским утром, через несколько дней после моих бесед с Труном и Хинтоном, я отправился в дерматологическую клинику Колумбийского университета на 51-й улице Манхэттена. Линдси Бордон [Lindsey Bordone]дежурный терапевт, должна была посмотреть в тот день 49 пациентов. К 10 утра приёмная была заполнена людьми. Бородатый мужчина лет 60 сидел в углу, скрывая сыпь на шее шарфом. Беспокойная парочка сжалась над газетой.

Бордон быстро принимала пациентов. В освещённой лампами дневного света задней комнате медсестра за компьютером давала краткие характеристики – «пятьдесят лет от роду, без истории болезни, новая подозрительная точка на коже» – а затем Бордон с развевающимися белыми волосами спешила в смотровую.

Молодой человек возрастом чуть более 30 лет с чешуйчатой красной сыпью на лице. Во время осмотра чешуйка кожи отделилась и упала с его носа. Бордон подвела его к свету и тщательно осмотрела кожу, а потом сфокусировала на ней переносной дермоскоп.

Молодой человек возрастом чуть более 30 лет с чешуйчатой красной сыпью на лице. Во время осмотра чешуйка кожи отделилась и упала с его носа. Бордон подвела его к свету и тщательно осмотрела кожу, а потом сфокусировала на ней переносной дермоскоп.

«Перхоть есть у вас?» – спросила она.

Человек удивился. «Да», – сказал он.

«Ну а это лицевая перхоть, – сказала ему Бордон. – Тяжёлый случай. Но вопрос в том, почему она проявилась сейчас, и почему ухудшается. Вы не начинали применять какое-нибудь новое средство для волос? Нет ли у вас в семье необычных стрессов?»

«Стресс был, однозначно», – сказал он. Он недавно потерял работу, и страдал от финансовых последствий.

«Ведите дневник, – посоветовала она. – Мы сможем определить наличие связи». Она выписала ему рецепт на стероидный крем и попросила прийти через месяц.

В следующей комнате ожидал молодой человек, помощник адвоката, с россыпью прыщиков на коже головы. Он поморщился, когда Бордон ощупывала его. «Себорейная экзема», – сказала она, закончив осмотр.

Женщина в соседней комнате была без одежды, в больничной робе. В прошлом ей ставили диагноз «меланома» и она старательно посещала предварительные обследования. Бордон прошлась по её коже. Заняло это 20 минут, но она была скрупулёзной и последовательной, перебирая пальцами родинки и пятнышки, называя вслух диагнозы. Там были родинки и кератоз, но ни одной меланомы или карциномы.

«Вроде бы всё в порядке», – радостно подытожила она. Женщина вздохнула с облегчением.

Так и продолжалось: Бордон пришла, увидела, диагностировала. Она выглядела не как койот Хинтона, а как бегун-маньяк, пытающийся справиться с делами, прокручивающимися под его ногами как полотно бегущей дорожки. Когда она записывала свои отметки, я спросил её по поводу диагностики по версии Труна: картинка, снятая айфоном и отправленная по почте в удалённую сеть, выдающей мнение без сомнений, но и без объяснений. Такой дерматолог, как Бордон, работая на полную ставку, сможет увидеть порядка 200 000 пациентов за всю карьеру. Стэнфордский алгоритм переварил порядка 130 000 дел за три месяца. Каждый новый дерматолог вынужден начинать обучение с нуля, а алгоритм Труна продолжает поглощать данные, расти и обучаться.

Бордон пожала плечами. «Если это поможет мне принимать решения с большей точностью, я с удовольствием приму его, – сказала она. – Мои пациенты могли бы сделать фотки своих проблем с кожей до приёма, это бы увеличило возможности клиники».

Звучало логично, и я вспомнил замечания Труна по поводу дополнения. Но в то время, как машины будут учиться всё больше, будут ли люди учиться всё меньше? Вечная забота родителя, ребёнок которого пользуется на телефоне проверкой правописания: что, если ребёнок перестанет учиться правильно писать слова? Это явление назвали «искажение автоматизации». Когда у автомобилей появятся системы автоматической помощи водителю, последние могут стать менее внимательными – примерно то же может случиться и в медицине. Возможно, Бордон – это одинокий Джон Генри в мире, где паровые молоты скоро появятся в онлайне. Но невозможно было не заметить, как её концентрация не нарушалась, и как серьёзно она подходила к каждому пятнышку и каждой родинке. Было бы это так, если бы она начала принимать помощь машин?

Я заметил ещё одну особенность при общении Бордон с пациентами. Они почти всегда уходили, чувствуя себя лучше. Их прощупали, изучили, с ними поговорили. Даже названия образований были смягчающими. В процессе было что-то обнадёживающее. Женщина, кожу которой проверили полностью, приободрилась и ушла с облегчением, а её волнение исчезло.

Диагностический момент, как описали бы его бразильские исследователи, наступал в виде внезапного озарения. Бордон, говоря «дерматит» или «экзема», как бы опознавала носорога: было такое чувство, что можно увидеть, как светится пирамидка из нейронов в задней части основания мозга, когда она опознаёт образование. Но визит на этом не заканчивался. Почти всегда Бордон проводила много времени, исследуя причины. Почему появились симптомы? Был ли это стресс? Новый шампунь? Менял ли кто-нибудь хлорку в бассейне? Почему сейчас?

Самым важным элементом клинических исследований было не «знание что» или «знание как» – не контроль над фактами дела, не распознавание образований. Он находился в третьей области знания: «знания почему».

Объяснения бывают простыми и сложными. Красный волдырь у вас на пальце оттого, что вы прикоснулись к горячему утюгу. Красный волдырь у вас на пальце оттого, что ожог возбудил каскад выработки простагландинов и цитокинов; этот процесс изучен пока ещё не полностью. Знать, почему – спрашивать, почему – значит, добыть ключ к объяснению, а объяснение подпитывает прорывы в медицине. Хинтон говорил по поводу игроков в бейсбол и физиков. Диагносты, искусственные или живые, играют роль игрока в бейсбол – опытного, но непонятного. Исследователи-медики будут в роли физика – так же оторванные от клинической практики, как теоретик от поля для бейсбола, но имеющие желание узнать «почему». Это удобное разделение ответственности – но может ли в нём скрываться потеря?

«Система глубинного обучения не обладает возможностью что-либо объяснять», – как прямо заявляет Хинтон. Чёрный ящик не умеет исследовать причины. Он говорит: «чем больше у ГО-системы становится возможностей, тем меньше она понятна со стороны. Извлекая всё больше признаков, она ставит всё лучшие диагнозы. Почему именно эти признаки были избраны среди миллионов особенностей – на этот вопрос ответа нет». Алгоритм может выдать решение проблемы, но не описать её.

В моей области, в онкологии, я не могу не заметить, каких успехов добились опытные практики, являющиеся одновременно и пытливыми исследователями. За последние несколько десятилетий амбициозные доктора стремились стать одновременно и бейсболистами и физиками. Они пытались использовать диагностические знания для определения патофизиологии заболевания. Почему несимметричная граница образования на коже предсказывает меланому? Почему некоторые меланомы спонтанно регрессируют и почему на этих местах появляются участки светлой кожи? Так получилось, что это наблюдение в результате связали с созданием самых мощных из используемых сегодня лекарств (оказалось, что осветление кожи – это иммунная реакция, работающая против меланомы). Цепочка открытий может начаться в клинике. Если всё больше случаев из клинической практике будет низводиться до обучающихся машин с непонятной схемой работы, если начнёт исчезать тесная связь скрытых и явных форм знаний – «знания как», «знания что» и «знания почему» – возможно ли, что мы будем лучше делать то, чем мы занимаемся, но меньше понимать, чем мы должны заниматься, и перестанем мыслить за пределами алгоритмического чёрного ящика?

Я пообщался по поводу нашего автоматизированного будущего с Дэвидом Бикерсом, главой отдела дерматологии в Колумбийском университете . «Поверьте, я пытался представить себе все последствия работы Труна, – сказал он. – Я не разбираюсь в математике этой работы, но я знаю, что такие алгоритмы могут изменить практику дерматологии. Потеряют ли врачи работу? Не думаю, но думаю, что нужно хорошенько подумать о том, как интегрировать такие программы в нашу практику. Как мы будем их оплачивать? Каковы юридические последствия ошибки компьютера? Умалит ли она нашу практику или наше представление о себе как о диагностах, из-за того, что мы будем полагаться на такие алгоритмы? Не придём ли мы к тому, что вместо докторов будем обучать техников?»

Он посмотрел на часы. Его ждал пациент, и он поднялся, чтобы уходить. «Я всю свою жизнь был учёным и диагностом, – сказал он. – Я знаю, как сильно пациент надеется на мои способности отличить злокачественное образование от доброкачественного. Также я знаю, что медицинское знание возникает из диагноза».

Он напомнил мне, что слово «диагноз» происходит от латинского diagnosis, dia «врозь» + gnosis «знание». Алгоритмы МО будут улучшать свои показатели лишь в таком знании «врозь» – разделение и классификация родинок и меланом. Но цельное знание превосходит эти алгоритмы, заточенные на определённые задачи. В медицинской области лучшие результаты приносит, скорее всего, комплексное знание.